Inteligencia Artificial Privacy-Preserving

Nuestra tecnología permite maximizar el potencial de los datos al mismo tiempo que preserva la privacidad, ya que los datos nunca se comparten.

“Federated Learning accelerates model development while protecting privacy.”

“Federated Learning: A managed process for combining models trained separately on separate data sets that can be used for sharing intelligence between devices, systems, or firms to overcome privacy, bandwidth, or computational limits.“

While Federated Learning is a nascent technology, it is highly promising and can enable companies to realize transformative strategic business benefits. "FL is expected to make significant strides forward and transform enterprise business outcomes responsibly.”

“Federated Learning: AI's new weapon to ensure privacy.”

“Federated Learning allows AI algorithms to travel and train on distributed data that is retained by contributors. This technique has been used to train machine-learning algorithms to detect cancer in images that are retained in the databases of various hospital systems without revealing sensitive patient data.”

Aprendizaje

Federado

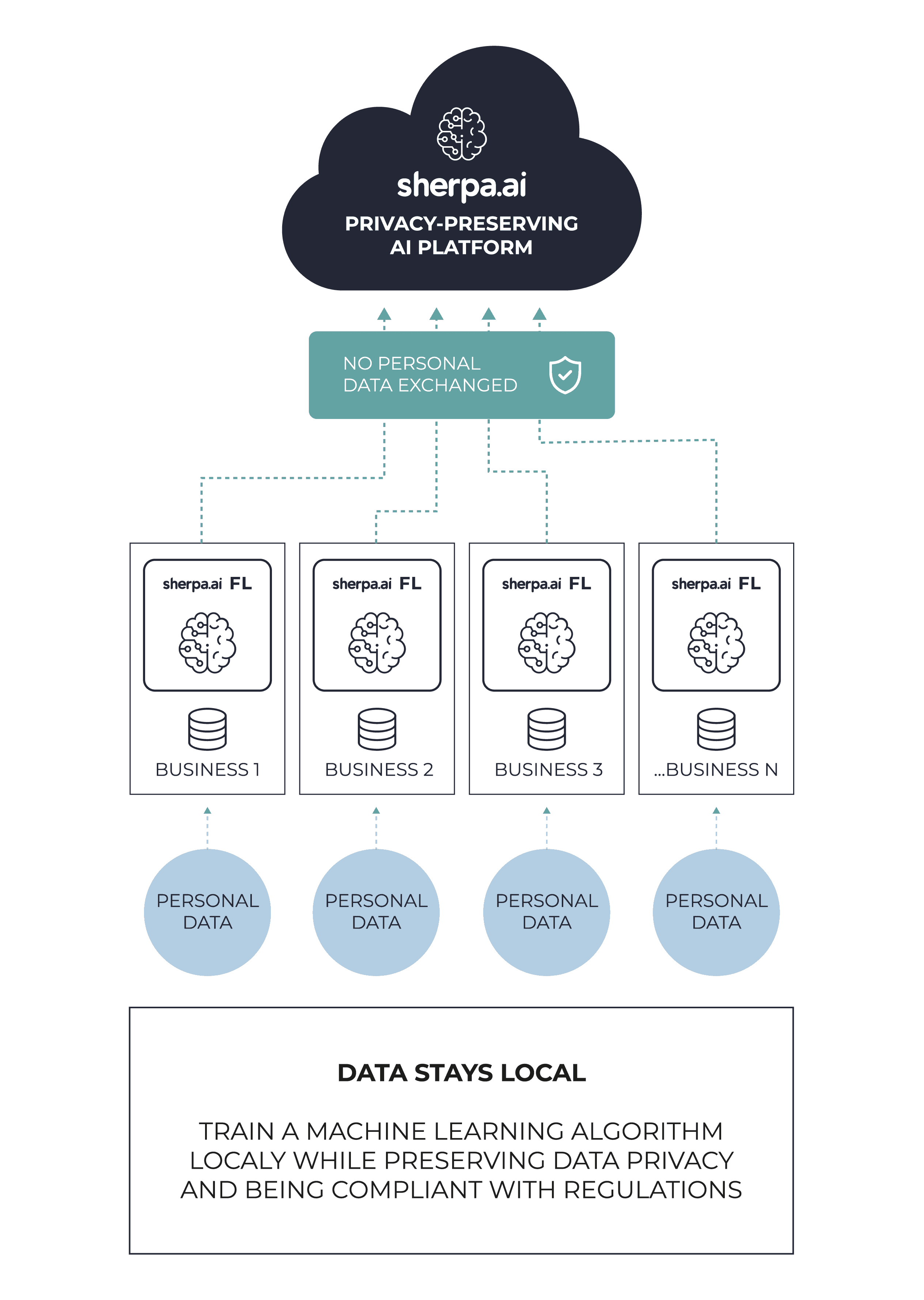

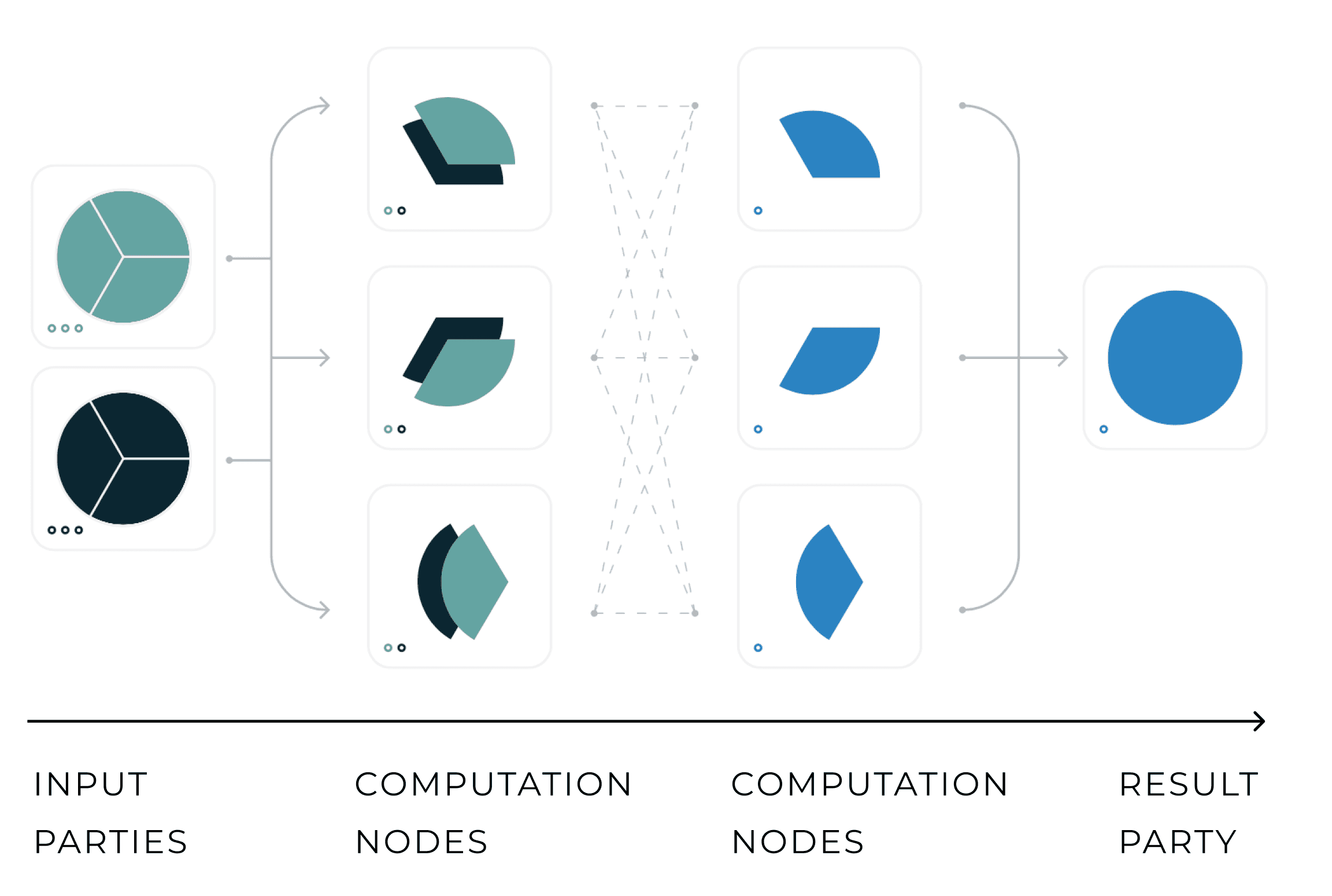

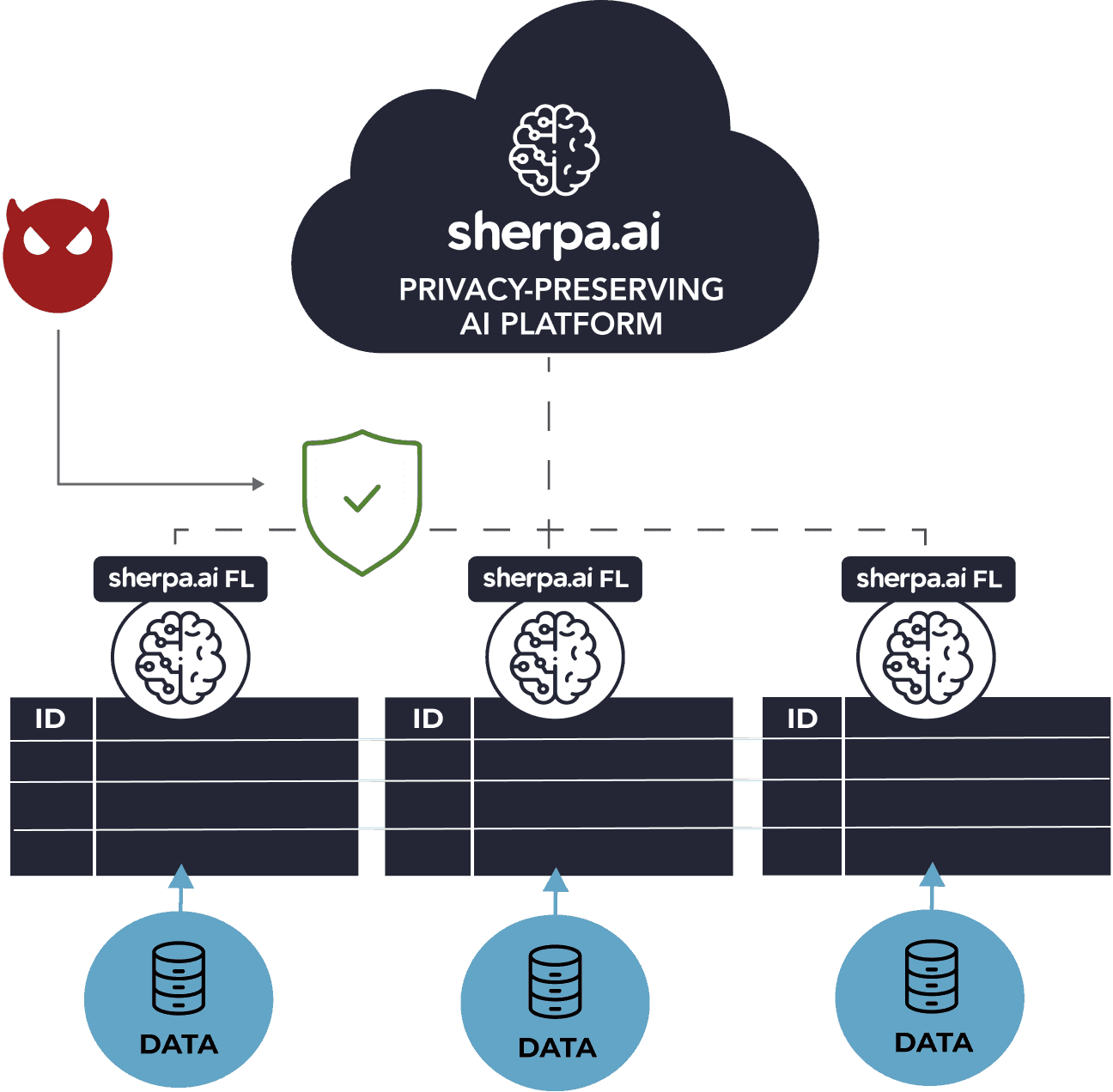

El aprendizaje federado es un paradigma de Machine Learning que permite entrenar modelos con datos distribuidos en diferentes sistemas o nodos (por ejemplo, datos ubicados en los smartphones, hospitales o bancos), al tiempo que garantiza la privacidad de los datos.

Esto se logra entrenando modelos localmente en cada nodo (por ejemplo, en cada hospital, en cada banco o en cada smartphone) y compartiendo solo los parámetros actualizados del modelo y agregándolos de forma segura para construir un mejor modelo global (los datos nunca salen del nodo y por lo tanto nunca se comparte).

Después de años de investigación, Sherpa.ai ha desarrollado la plataforma de aprendizaje federado más avanzada para la privacidad de datos, que incorpora tecnologías complementarias privacy-enhancing (p. ej., privacidad diferencial, cifrado homomórfico, computación multiparte segura).

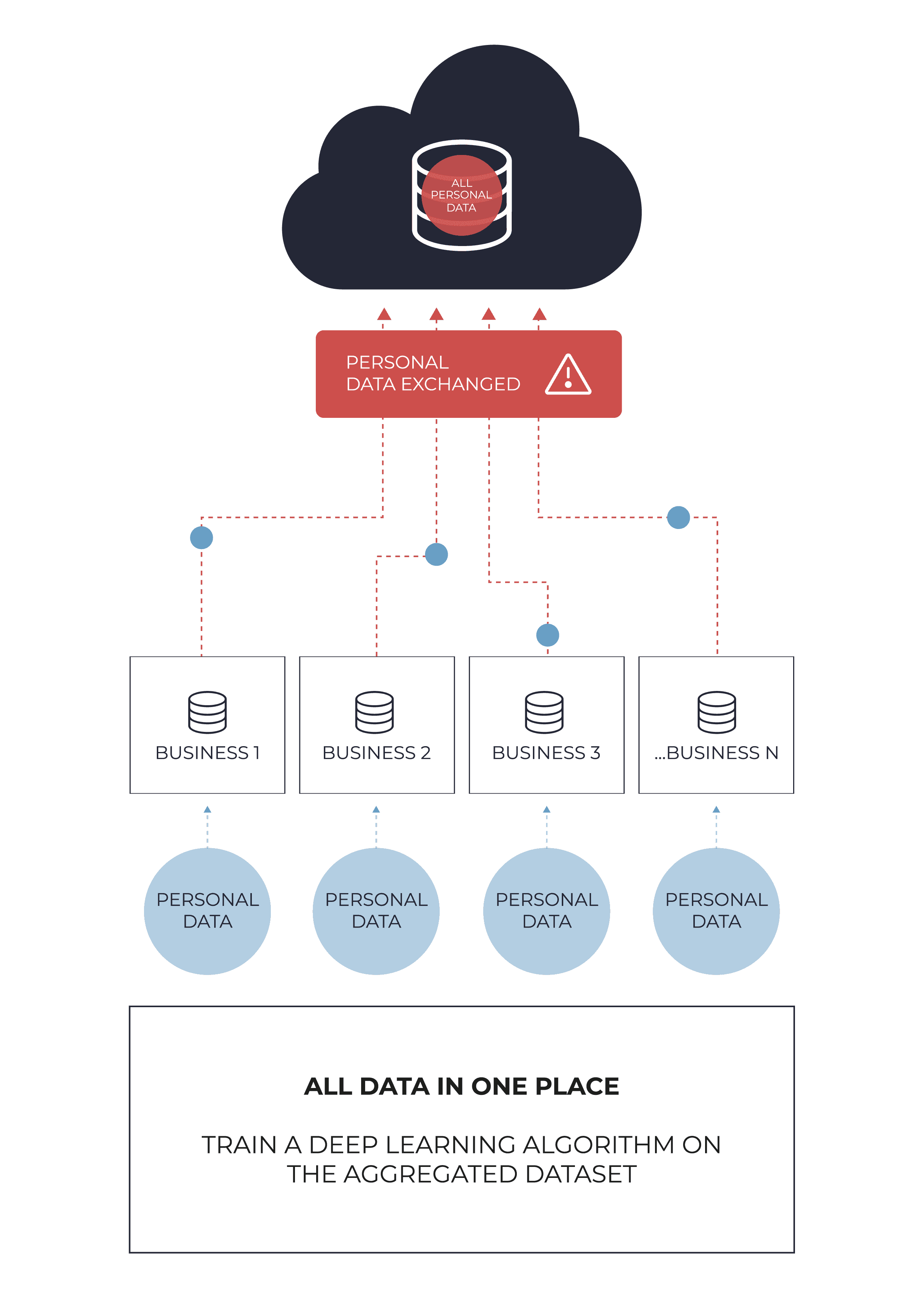

SOLUCION TRADICIONAL

- Mas riesgo de violación de privacidad.

- No cumple con la regulación.

- El control de datos se pierde una vez que sale del servidor.

- Gran superficie de ataque.

SOLUCIÓN DE APRENDIZAJE FEDERADO DE SHERPA.AI

- Maximiza el potencial de los modelos colaborativos sin compartir datos privados.

- Privacy by design.

- Cumplimiento normativo: los datos nunca salen del servidor de las partes involucradas.

- Menor riesgo de violaciones de privacidad. La superficie de ataque se reduce.

- Transparencia sobre cómo se entrenan los modelos y cómo se utilizan los datos.

¿CUÁNDO AYUDA EL APRENDIZAJE FEDERADO EN EL ENTRENAMIENTO DE MODELOS?

El aprendizaje federado es disruptivo en los casos en que es obligatorio garantizar la privacidad de los datos, ya que no es necesario compartirlos,

Cuando los datos contienen información confidencial o sensible, como información médica protegida, registros financieros o cualquier otra información privada que identifique a la persona.

Sin embargo, un mejor uso de los datos disponibles tendría un gran impacto para mejorar los procesos o resolver desafíos importantes como las enfermedades raras.

Cuando los datos no se pueden usar o compartir debido al cumplimiento normativo ya que están restringidos en sectores muy regulados, como los servicios financieros o el sector salud..

Cuando diferentes organizaciones quieren aprovechar sus datos sin compartirlos.

Por ejemplo, dos organizaciones competitivas podrían resolver un problema común a través de un modelo de capacitación colaborativo, pero no están dispuestas a compartir datos de propiedad con cada una debido a razones competitivas. El aprendizaje federado permite el entrenamiento de modelos colaborativos sin compartir datos.

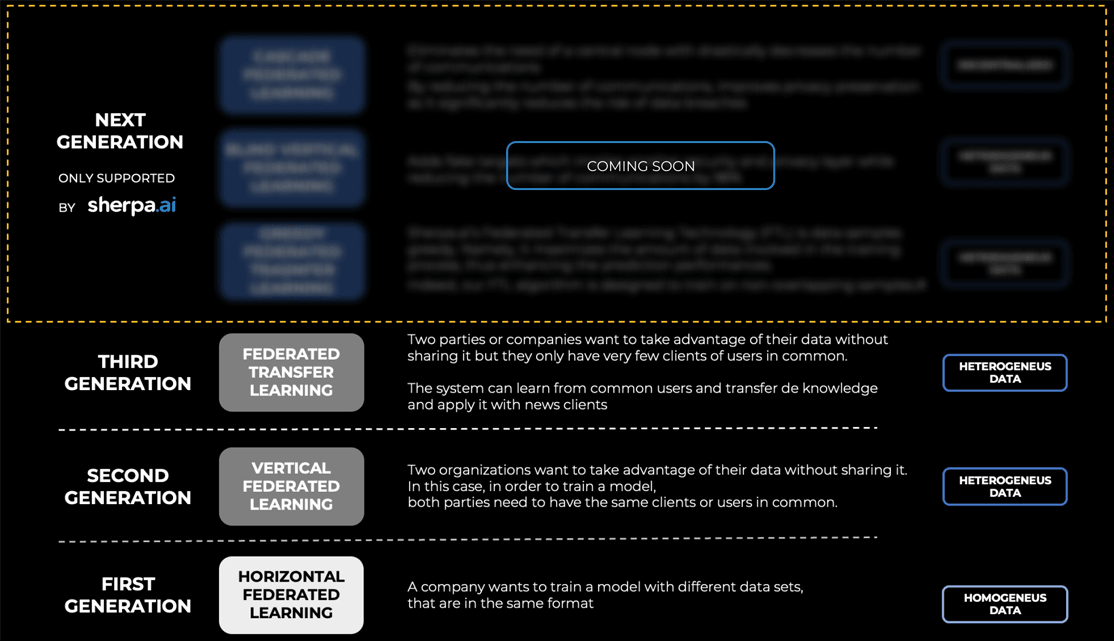

FEDERATED LEARNING GENERATIONS

EL RETO DEL ENTRENAMIENTO CON DATOS HETERÓGENOS

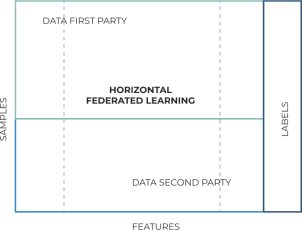

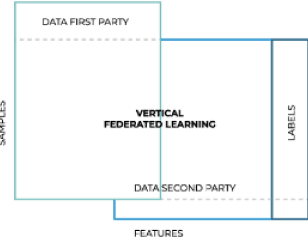

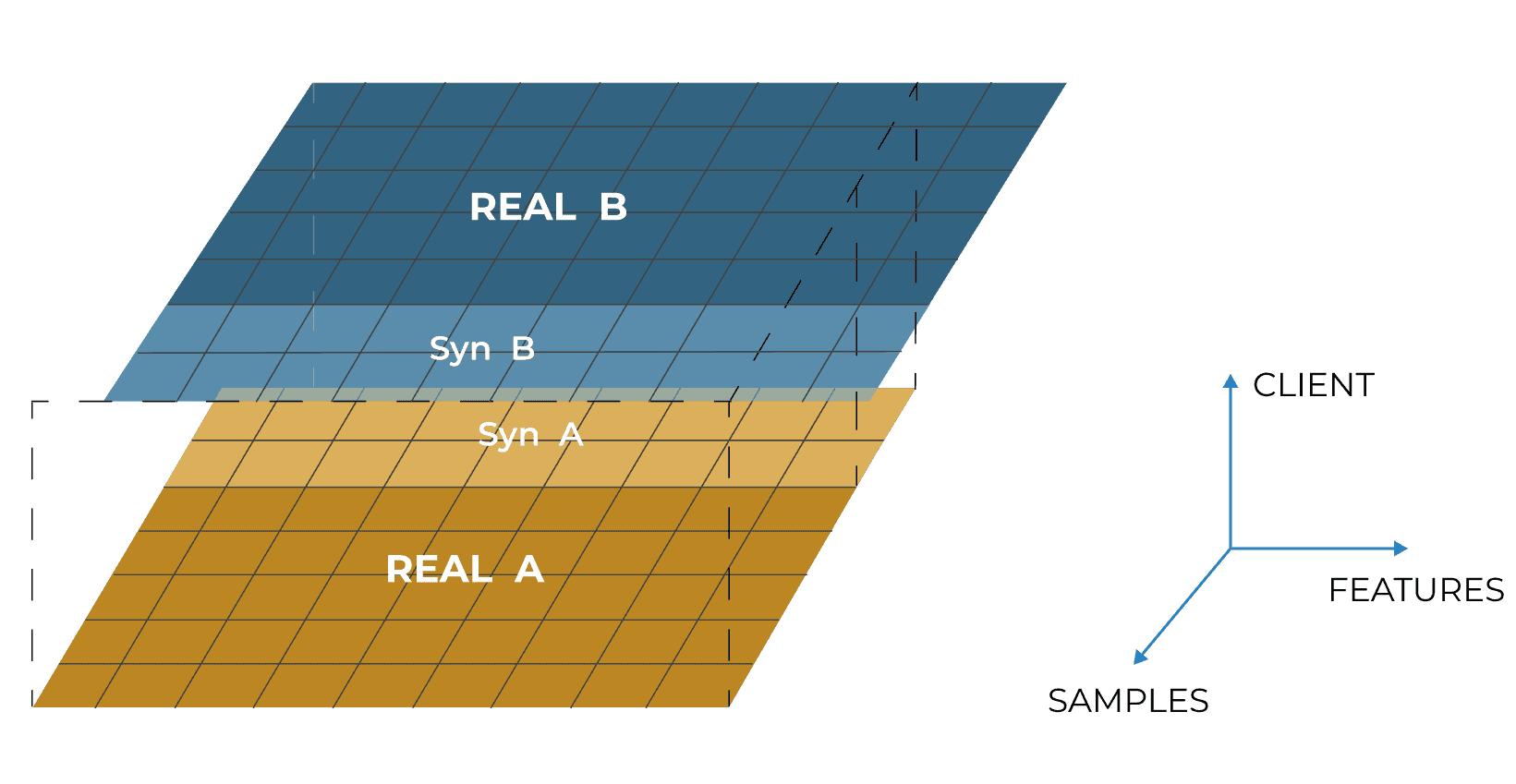

En Aprendizaje Federado Horizontal los datos son homogéneos. Esto significa que los conjuntos de datos en los diferentes nodos tienen las mismas características (columnas) pero difieren en las muestras. Por tanto, un modelo puede ser compartido entre las partes y se entrena de forma colaborativa.

En la mayoría de los escenarios reales, este no es así; ya que diferentes nodos normalmente contendrían datos heterogéneos, lo que significa que los datos difieren en características. Esto implica que no se puede utilizar el mismo modelo y hay que desarrollar nuevas técnicas.

Sherpa.ai puede permite el entrenamiento con datos heterogéneos ya que el aprendizaje federado vertical y el aprendizaje federado Transfer están integrados en su plataforma.

PARADIGMAS DE APRENDIZAJE FEDERADO

APRENDIZAJE FEDERADO HORIZONTAL

El aprendizaje federado horizontal se introduce en esos escenarios, donde los conjuntos de datos comparten el mismo espacio de características (mismo tipo de columnas) pero difieren en las muestras (diferentes filas).

El aprendizaje federado horizontal solo admite datos homogéneos, que son datos que tienen las mismas características.

P.ej. Los diferentes nodos tienen las mismas características (columnas) pero difieren en las muestras. Se puede utilizar el mismo modelo para ambos nodos.

Use cases: Diagnóstico de enfermedades.

APRENDIZAJE FEDERADO VERTICAL

El aprendizaje federado vertical se aplica cuando dos partes tienen muestras con usuarios que se superponen, pero tienen características comunes limitadas.

El aprendizaje federado vertical admite datos heterogéneos, donde diferentes nodos tienen conjuntos de datos con usuarios comunes, pero con características diferentes. Con datos heterogéneos, no se puede utilizar el mismo modelo y se deben desarrollar nuevas técnicas.

Use cases: dos tipos diferentes de empresas en la misma área pueden tener los mismos usuarios; sin embargo, las características de datos que posee cada uno difieren. Por ejemplo, un banco tendría registros de crédito mientras que una empresa de telecomunicaciones tendría un historial de navegación.

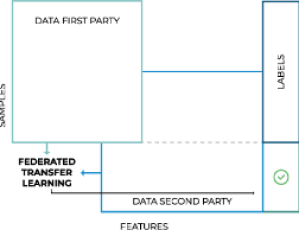

APRENDIZAJE FEDERADO TRANSFER

El aprendizaje de transferencia federado se aplica cuando dos o más partes tienen muestras con usuarios limitados que se superponen y características comunes limitadas

El sistema puede aprender de usuarios comunes en un conjunto de datos y transferir el conocimiento para aplicarlo con nuevos clientes.

Use cases: dos compañías de seguros podrían mejorar la detección de fraudes, entrenando modelos a través del aprendizaje federado, de modo que ambas compañías tuvieran un algoritmo predictivo de alta precisión, pero no compartirían sus datos comerciales con la otra parte.

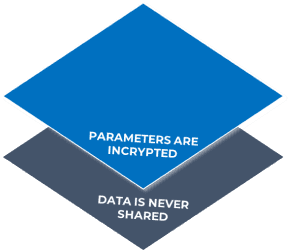

TWO-LAYER PRIVACY AND SECURITY SYSTEM

- Data is never shared, only learnings

- Learnings/model parameters are protected through different Privacy-Enhancing Technologies like Homomorphic Encryption, Secure Multiparty Computation or Differential Privacy

- Sherpa.ai applies PETS to parameters and since the quantities to be encrypted are more compact than full data, this leads to reduction of:

- Communications

- Computational cost in the operations on encrypted data

- Carbon footprint

DATA IS NEVER SHARED

FEDERATED LEARNING

Federated Learning is not enough. Therefore Sherpa.ai has developed a platform that incorporates complementary Privacy-Enhancing Technologies (Differential Privacy, Secure Multi-party Computation or Homomorphic Encryption among others) to ensure robustness of the platform.

Sherpa.ai's platform has revolutionary potential for heavily regulated sectors like Healthcare or Financial Services, where privacy as well as regulatory compliance are essential. By adding complementary technologies to ensure privacy is maintained, Sherpa.ai unlocks new scenarios of development and collaboration between organizations.

PARAMETERS ARE PROTECTED

PRIVACY-ENCHANCING TECNOLOGIES (PETs)

Federated Learning is not enough. Therefore Sherpa.ai has developed a platform that incorporates complementary Privacy-Enhancing Technologies (Differential Privacy, Secure Multi-party Computation or Homomorphic Encryption among others) to ensure robustness of the platform.

Sherpa.ai's platform has revolutionary potential for heavily regulated sectors like Healthcare or Financial Services, where privacy as well as regulatory compliance are essential. By adding complementary technologies to ensure privacy is maintained, Sherpa.ai unlocks new scenarios of development and collaboration between organizations.

TECNOLOGÍAS PRIVACY-PRESERVING

(PETs)

El aprendizaje federado no es suficiente. Por lo tanto, Sherpa.ai ha desarrollado una plataforma que incorpora tecnologías complementarias de mejora de la privacidad (privacidad diferencial, computación multi parte segura o cifrado homomórfico, entre otras) para garantizar la solidez de la plataforma.

La plataforma de Sherpa.ai tiene un potencial revolucionario para sectores fuertemente regulados como el de la atención médica o los servicios financieros, donde la privacidad y el cumplimiento normativo son esenciales. Al agregar tecnologías complementarias para garantizar que se mantenga la privacidad, Sherpa.ai abre nuevos escenarios de desarrollo y colaboración entre organizaciones.

PRIVACIDAD DIFERENCIAL

La privacidad diferencial es una técnica estadística para proporcionar agregaciones de datos, evitando la fuga de registros de datos individuales. Esta técnica garantiza que los agentes maliciosos que intervienen en la comunicación de parámetros locales no puedan rastrear esta información hasta las fuentes de datos, lo que agrega una capa adicional de privacidad de datos.

PRIVACIDAD DIFERENCIAL POR ENCIMA DE TODO

La privacidad diferencial a nivel de datos es la implementación más común y limitante. No proporciona un buen equilibrio entre precisión y privacidad, lo que hace que el entrenamiento de modelos sea extremadamente complejo, cuando no imposible.

El enfoque de privacidad diferencial por encima de todo de Sherpa.ai proporciona un compromiso empírico de última generación entre precisión y privacidad. Con el uso de la Privacidad Diferencial, nos aseguramos de que no se puedan obtener datos enmascarando la información original con ruido controlado y adaptativo, manteniendo el rendimiento del algoritmo predictivo. Esto evita que agentes malintencionados obtengan, rastreen o deduzcan datos de los clientes incluso con técnicas de ingeniería inversa.

A NIVEL DE AGREGADOR

Solo Sherpa.ai puede agregar ruido a nivel de agregación sin disminuir la precisión del modelo.

A NIVEL DE PARÁMETROS DEL MODELO

Se puede agregar ruido a nivel de parámetro creando una cancelación parcial de ruido a nivel de agregación

. El mecanismo de cálculo de sensibilidad avanzado de Sherpa.ai implica un análisis local preciso de los datos para ajustar el nivel de ruido óptimo que se aplicará

A NIVEL DE DATOS

Implementación más común y limitante. No proporciona un buen equilibrio entre precisión y privacidad, lo que hace que el entrenamiento del modelo sea extremadamente complejo o imposible y daña la naturaleza de los datos.

BLIND LEARNING

A challenge in the standard Vertical Federated Learning is to reduce the huge number of communications in a distributed scenario

Blind Learning is a fundamental functionality for Federated Learning for heterogeneous data, achieved through the generation of fake targets:

Fake target generation obeys two principles:

- Different fake targets are generated for each example (to enhance privacy);

- There must be a general rule (working not only on available examples) to map a fake target to the corresponding real label (to let the trained model generalize well).

With Blind Learning the number of communications are reduced by over 99%, with the following benefits:

- Lower costs

- Lower risk of data breaches which massively improves security and privacy

- Lower energy consumption and carbon footprint

CIFRADO HOMOMORFICO

El cifrado homomórfico es una clase específica de esquemas de cifrado que permite a los usuarios ejecutar ciertas operaciones en los datos mientras los datos permanecen en su estado cifrado. Homomórfico es un término del álgebra avanzada que habla de la relación de preservación de la estructura entre el texto sin formato y los datos cifrados. Dado que los resultados de la computación en datos/texto cifrado son idénticos a los de datos/texto sin cifrar, estas funciones pueden considerarse como homomorfismos.

Con el cifrado homomórfico de Sherpa.ai, uno puede realizar algunos cálculos en la nube utilizando datos, pero conservando la privacidad. Al usar HE, puede enviar la versión cifrada de sus datos a la nube, realizar el cálculo allí y recuperar el resultado cifrado que puede descifrar más adelante.

Todos estos pasos no requieren que el cliente permanezca conectado. (Beneficio HE). Entonces, las ideas principales sobre HE son: Se utiliza en la agregación de los parámetros. Las principales ventajas son que esta agregación se realiza utilizando los parámetros cifrados y el número de comunicaciones es muy bajo en comparación con otras técnicas de defensa.

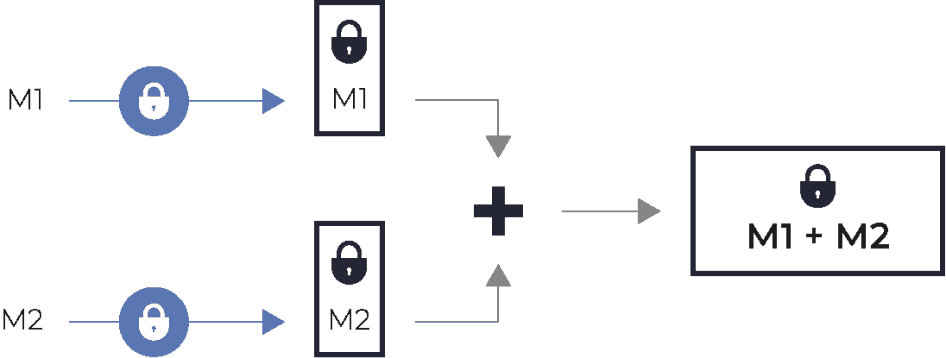

COMPUTACIÓN SEGURA MULTI-PARTE

La computación segura multi-parte (Secure Multi Party Computation, SMPC) es un subcampo de la criptografía con el objetivo de crear métodos para que las partes calculen conjuntamente una función sobre sus entradas mientras mantienen esas entradas privadas.

A diferencia de las tareas criptográficas tradicionales, donde la criptografía garantiza la seguridad y la integridad de la comunicación o el almacenamiento y el adversario está fuera del sistema de los participantes (un espía del remitente y el receptor), la criptografía en este modelo protege la privacidad de los participantes entre sí, lo que hace mucho más más difícil corromper a los participantes.

Sherpa.ai ha desarrollado un protocolo criptográfico que distribuye el cómputo de datos de diferentes fuentes para garantizar que nadie pueda ver los datos de otros, sin la necesidad de confiar en un tercero.

Al hacer esto, se garantiza que los datos confidenciales de su empresa estén protegidos, sin socavar su capacidad para adquirir toda la información necesaria a partir de estos datos.

RESOLUCIÓN DE ENTIDADES PRIVADAS

Cuando los conjuntos de datos se distribuyen entre varias organizaciones, la identificación de las entidades correspondientes se convierte en un problema.

Con el uso de técnicas criptográficas de vanguardia, la sincronización e identificación de estos conjuntos de datos es posible mientras se protege la privacidad y se mantiene la precisión de los modelos entrenados.

Intersección de conjunto privado de datos (Private Set Intersection, PSI) determina la intersección de muestras de todas las partes. Los alinea comparando identificadores cifrados/encriptados (por ejemplo, nombre completo, número de documento de identidad… o combinación de varios identificadores). Nuestra tecnología de punta, basada en la separación de n-gramas, puede superar los errores tipográficos en los identificadores. Sin embargo, PSI hace que los identificadores de la intersección sean visibles para todas las partes, lo que puede ser problemático en algunos casos.

PSI revela membresía de intersección que está prohibida en la mayoría de los escenarios del mundo real. Unión de conjunto de datos privados (Private Set Union, PSU) permite que cada parte mantenga información confidencial para sí misma. PSU no revela los miembros de la intersección.

PRUEBA DE CONOCIMIENTO CERO

La prueba de conocimiento cero (Zero-Knowledge Proof, ZKP) es un método de encriptación que permite verificar información específica a otra parte sin revelar la información en sí.

ZKP se aplica a la defensa contra ataques de inferencia en la Intersección de Conjunto Privado de datos (PSI). Con PSI, dos organizaciones pueden calcular la intersección de sus datos cifrados sin compartirlos. No se revela ningún contenido excepto los elementos que forman parte de la intersección.

OTRAS TECNOLOGÍAS INTEGRADAS

PERSONALIZACIÓN

Sherpa.ai aborda el problema de los datos sesgados de forma personalizada y se ajusta perfectamente a la singularidad de cada cliente utilizando técnicas innovadoras que preservan el aprendizaje global y adaptan el conocimiento a cada individuo. Esto se logra modificando dinámicamente las funciones de pérdida del dispositivo en cada ronda de aprendizaje para que el modelo resultante sea imparcial hacia cualquier usuario.

GENERACIÓN DE DATOS SINTÉTICOS

Los datos sintéticos sirven como una forma de proteger la privacidad de los datos. Muchas veces, los datos reales contienen información privada y confidencial del usuario que no se puede compartir libremente. Para preservar esta privacidad, se toman diferentes enfoques que a menudo resultan en la omisión de datos que conduce a una pérdida general de información y utilidad.

La tecnología de Sherpa.ai hace uso de la generación avanzada de datos sintéticos para eliminar las lagunas de seguridad, como la membresía. Con esta solución no convencional, se gana la capacidad de alejarse del uso de métodos estándar, lo que reduce en gran medida los costos de comunicación sin degradar la precisión del modelo predictivo. Esto genera la capacidad de obtener la estructura subyacente y mostrar la misma distribución estadística de los datos originales, haciéndolos indistinguibles de los reales.

DEFENSAS CONTRA

ATAQUES ADVERSARIALES

Se han desarrollado soluciones técnicas para abordar las vulnerabilidades específicas de la IA para prevenir y controlar los ataques que intentan manipular el conjunto de datos de entrenamiento, las entradas diseñadas para hacer que el modelo cometa un error o las fallas del modelo.

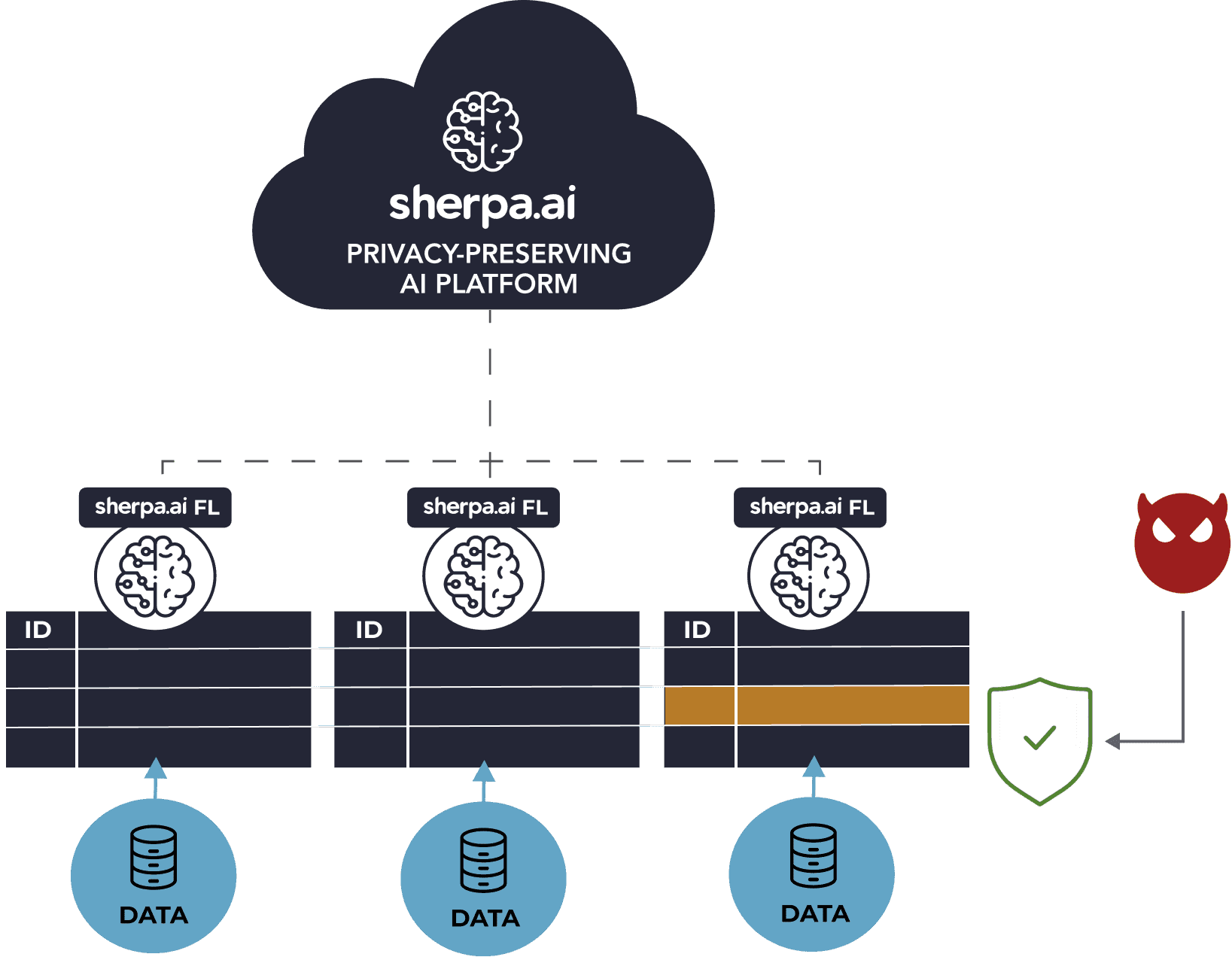

DEFENSA CONTRA ATAQUES A LA PRIVACIDAD/INFERENCIA

Los modelos de aprendizaje federado, si no se evitan, se pueden engañar para que proporcionen predicciones incorrectas y puedan dar cualquier resultado deseado. El proceso de diseñar una entrada de una manera específica para obtener un resultado incorrecto es un ataque adversario. Estos ataques tienen como objetivo inferir información de los datos de entrenamiento.

DEFENSA CONTRA

ATAQUES DE DATO

Se han desarrollado soluciones técnicas para abordar las vulnerabilidades específicas de la IA para prevenir y controlar los ataques que intentan manipular el conjunto de datos de entrenamiento, las entradas diseñadas para hacer que el modelo cometa un error o las fallas del modelo.

La mejor manera de comprobar si una defensa es satisfactoria es probarla con diferentes tipos de ataques. Por ello, se han diseñado una amplia gama de ataques para comprobar que los modelos son completamente privados.

DEFENSA CONTRA

ATAQUES DE INFERENCIA DE MEMBRESÍA

Los ataques de inferencia de membresía crean fugas que perjudican la preservación de la privacidad. Gracias al potencial de Sherpa.ai en Privacidad Diferencial se han desarrollado modelos de defensa capaces de proteger la identidad de los datos. Por lo tanto, se han eliminado los ataques de inferencia destinados a revelar quién es el propietario de los datos utilizados para entrenar un modelo de aprendizaje.

Cumpliendo en todo momento con los requisitos organizativos y garantizando la privacidad de los datos, de acuerdo con la legislación vigente.

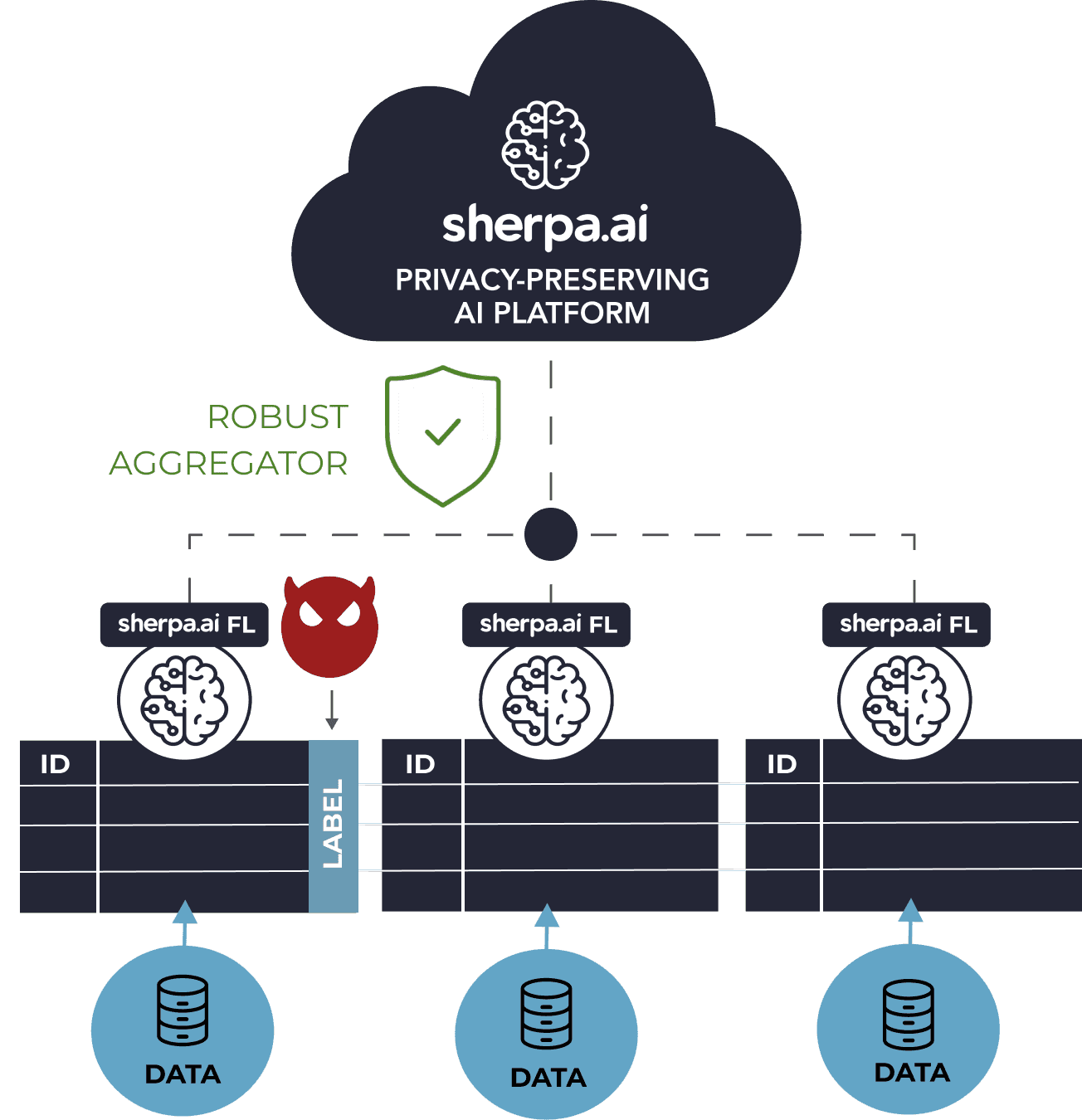

DEFENSA CONTRA ATAQUES DE ENVENENAMIENTO

Los ataques de envenenamiento persiguen comprometer el modelo de entrenamiento global. Aquí, los usuarios malintencionados inyectan datos de entrenamiento falsos con el objetivo de corromper el modelo aprendido, lo que afecta el rendimiento y la precisión del modelo.

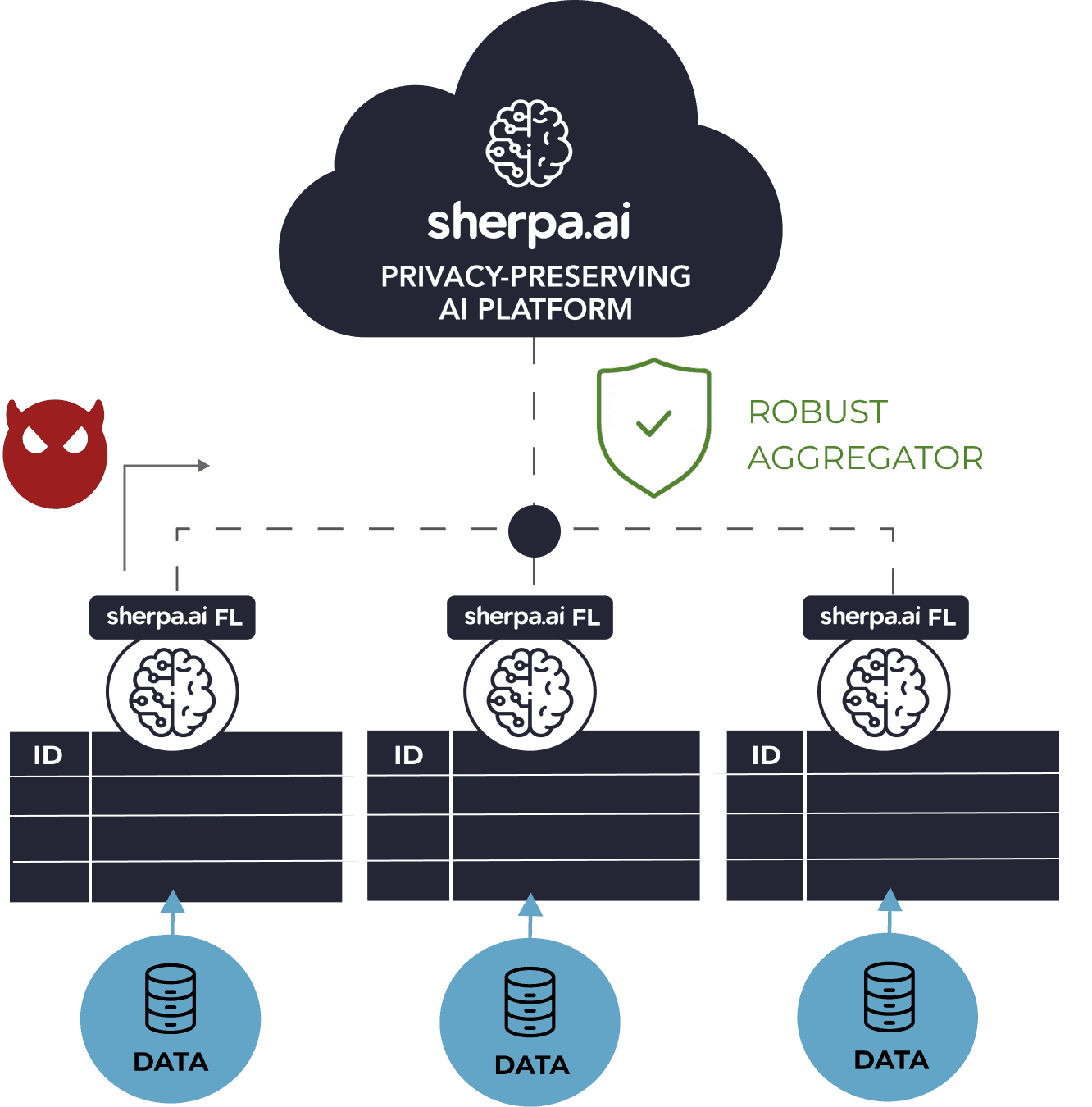

DEFENSA CONTRA

ATAQUES BIZANTINOS

Los ataques bizantinos perjudican el rendimiento del modelo en general y lo dañan hasta que se vuelve defectuoso. Por lo tanto, es crucial hacer que los modelos de aprendizaje federado sean resistentes a estas fallas donde los datos se comportan de manera caprichosa.

Con los mecanismos avanzados de Sherpa.ai se asegura la defensa del modelo federado frente a ataques maliciosos destinados a reducir el rendimiento del modelo. Por tanto, la protección se basa en la identificación de aquellos clientes con un comportamiento anómalo para evitar que participen en el proceso de agregación.

DEFENSA CONTRA

ATAQUES DE PUERTA TRASERA

El objetivo de estos ataques es inyectar sigilosamente una tarea secundaria en el modelo global. Esto hace que los clientes adversarios sean doblemente atacados y, por lo tanto, las actualizaciones del modelo de aprendizaje difieren de las actualizaciones de los clientes no malintencionados.

Se han establecido algoritmos sin precedentes capaces de anular los ataques de puerta trasera. Con esta tecnología se consigue un aumento del rendimiento y seguridad de sus modelos.

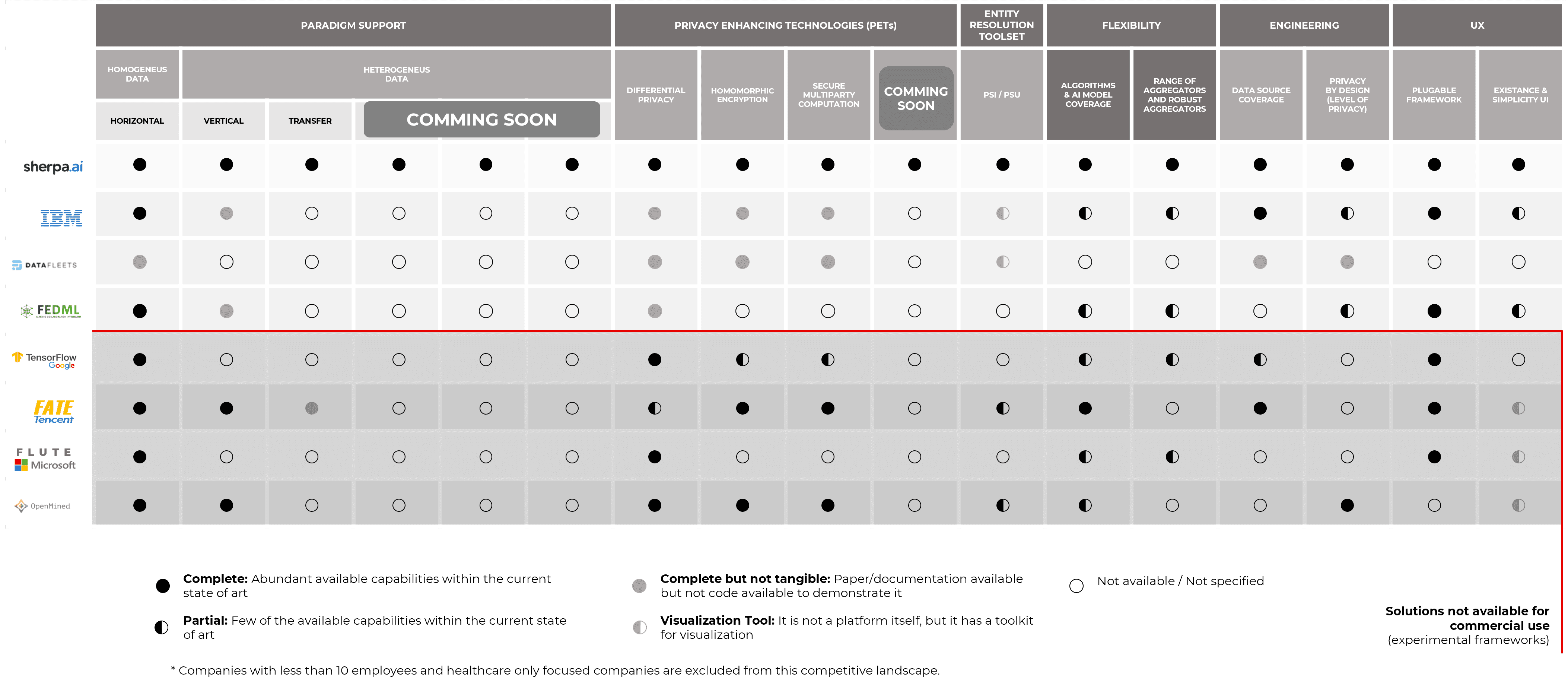

¿CÓMO SE COMPARA

SHERPA.AI CON OTRAS SOLUCIONES?

Sherpa.ai se compara favorablemente con otras tecnologías de la competencia. Hemos elaborado una tabla para ayudarte a comprender como se compara Sherpa.ai con otras soluciones en el mercado.

QUOTES DE

NUESTRO EQUIPO

Hemos alcanzado los niveles más altos en la implementación de algoritmos para la plataforma de Inteligencia Artificial con privacidad de datos de Sherpa.ai, con las metodologías más avanzadas de la matemática aplicada

Enrique Zuazua, Ph.D.

Senior Associate Researcher in Algorithms of Sherpa.ai

Sherpa está liderando el modo en el que se construirán las soluciones de inteligencia artificial, preservando la privacidad del usuario en todas sus formas

Tom Gruber

Chief AI Strategy Officer at Sherpa.ai